Summary

View original tweet →Khai Phá Sức Mạnh Của LLM Cục Bộ: Hướng Dẫn Toàn Tập

Trong thế giới AI đang phát triển như vũ bão, việc chạy các mô hình ngôn ngữ lớn (LLM) ngay trên máy tính cá nhân đã trở thành một "cú twist" cực kỳ thú vị cho dân dev và những ai đam mê công nghệ. Mới đây, một thread trên Twitter của anh @arpit20adlakha đã chia sẻ 10 bài hướng dẫn siêu xịn để thiết lập và sử dụng LLM cục bộ, nhấn mạnh các lợi ích như bảo mật, kiểm soát và hiệu suất. Bài viết này sẽ "mổ xẻ" sâu hơn những insights từ thread đó, giúp bạn hiểu rõ hơn về các công cụ và cách triển khai LLM tại nhà.

Thread mở đầu bằng một câu chào sân cực cuốn: "Tất tần tật về việc chạy LLM cục bộ: 10 bài hướng dẫn chi tiết để bạn làm được điều đó." Nghe thôi đã thấy hấp dẫn rồi đúng không? Nào, cùng khám phá loạt công cụ và kỹ thuật giúp bạn "bẻ lái" AI mà không cần phụ thuộc vào mấy dịch vụ đám mây nhé!

1. Video hướng dẫn của @Rob_Mulla: "Nhập môn LLM cục bộ"

Bài hướng dẫn đầu tiên giới thiệu một video của anh @Rob_Mulla, hướng dẫn chi tiết cách thiết lập LLM trên máy cá nhân. Đây là "món khai vị" hoàn hảo cho những ai mới bắt đầu và còn đang lơ ngơ không biết bắt đầu từ đâu.

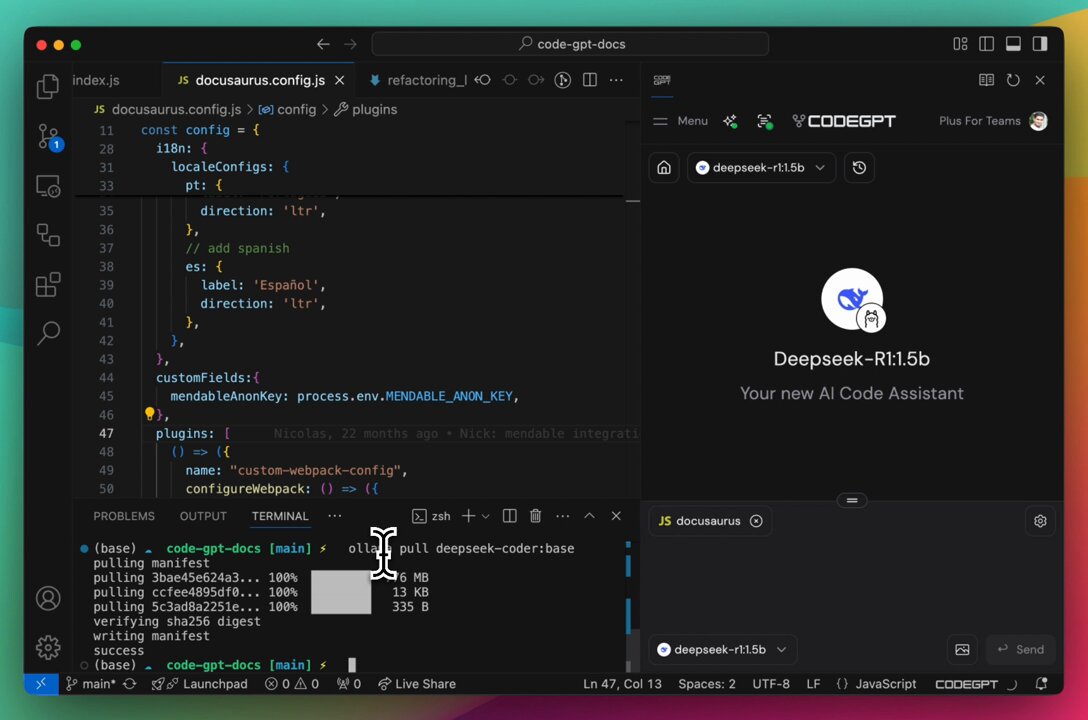

2. Deepseek-coder: "Trợ thủ đắc lực cho dân code"

Tiếp theo, thread nhắc đến Deepseek-coder, một công cụ tích hợp với Visual Studio Code để tăng tốc độ code. Chỉ cần set nó làm model tự động hoàn thành, bạn sẽ thấy workflow của mình mượt mà hơn hẳn. DataCamp cũng từng nhấn mạnh rằng các framework như GPT4All hay LM Studio rất thân thiện với người dùng khi triển khai LLM cục bộ.

3. @LMStudioAI: "Bảo mật là chân ái"

Bài hướng dẫn thứ ba nói về @LMStudioAI, một công cụ đảm bảo dữ liệu của bạn luôn được giữ riêng tư và chỉ nằm trên máy của bạn. Trong thời đại mà ai cũng lo lắng về bảo mật dữ liệu, thì việc giữ thông tin nhạy cảm "trong nhà" là một điểm cộng to đùng của LLM cục bộ.

4. DeepSeek R1 Distill: "LLM trên iPhone? Chuyện nhỏ!"

Thread còn nhắc đến DeepSeek R1 Distill, một công cụ chạy LLM cục bộ ngay trên iPhone. Nghe có vẻ "ảo ma Canada" nhưng thực sự là bạn có thể tận dụng sức mạnh AI ngay trên thiết bị di động của mình.

5. @WebGPU: "Chạy LLM ngay trên trình duyệt"

Tiếp theo là @WebGPU, một công cụ cho phép chạy LLM cục bộ ngay trên trình duyệt thông qua Transformers.js. Với sự bùng nổ của các giải pháp mã nguồn mở, công cụ này thực sự là "vũ khí bí mật" cho những ai muốn thử nghiệm AI mà không cần cài đặt phức tạp.

6. @ollama: "Llama2, Mistral và hơn thế nữa"

Thread cũng giới thiệu @ollama, một nền tảng cho phép bạn chạy các LLM mã nguồn mở như Llama2 hay Mistral trực tiếp trên máy tính. Sự linh hoạt này giúp bạn thoải mái "vọc vạch" các mô hình mà không bị ràng buộc bởi dịch vụ đám mây.

7. RAG offline: "Tự tạo API OpenAI miễn phí"

Bạn có thể chạy các LLM như Llama 3.1 hay Mistral với Retrieval-Augmented Generation (RAG) offline, tạo ra một API giống OpenAI nhưng hoàn toàn miễn phí. Tính năng này không chỉ tăng hiệu suất mà còn cho phép bạn tùy chỉnh mô hình theo ý muốn.

8. Công cụ C++ của @ggerganov: "Nhẹ mà chất"

Một công cụ nhẹ nhàng nhưng mạnh mẽ từ @ggerganov dành cho các mô hình Llama, với ít phụ thuộc và khả năng tự biên dịch. Đây là lựa chọn lý tưởng cho những ai thích sự gọn nhẹ và kiểm soát tối đa.

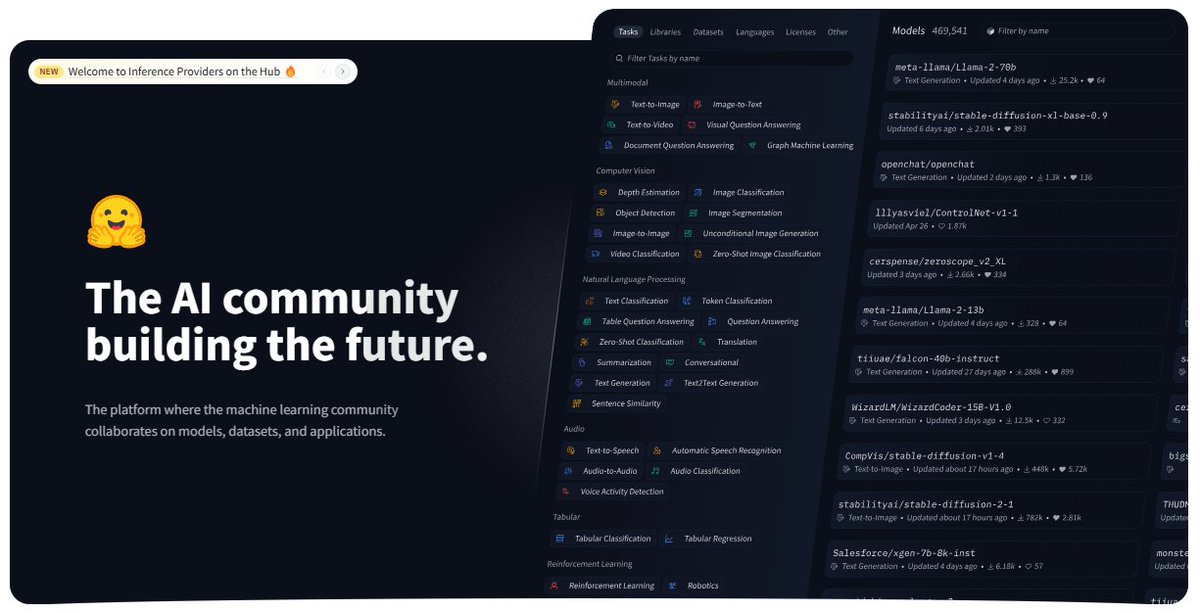

9. @huggingface: "Kho báu của dân AI"

Cuối cùng, thread nhắc đến @huggingface, một nền tảng với hơn 558,000 mô hình transformer LLM. Đây thực sự là "thiên đường" cho những ai muốn khám phá và triển khai AI cục bộ.

Kết luận: "Tương lai là cục bộ!"

Anh @arpit20adlakha khép lại thread bằng lời kêu gọi mọi người follow để cập nhật thêm nhiều insights hay ho. Thread này thực sự là một tài nguyên quý giá cho bất kỳ ai muốn khám phá thế giới LLM cục bộ, nhấn mạnh tầm quan trọng của bảo mật, hiệu suất và các công cụ mã nguồn mở.

Trong thời đại AI ngày càng phức tạp, việc chạy LLM cục bộ không chỉ giúp bạn kiểm soát tốt hơn mà còn mở ra cơ hội sáng tạo và đổi mới trong phát triển ứng dụng AI. Tương lai của AI chắc chắn sẽ là "cục bộ", và những công cụ, tài nguyên được đề cập trong thread này đang mở đường cho một kỷ nguyên mới của các giải pháp AI mạnh mẽ và dễ tiếp cận.